经济观察报 记者 郑晨烨在4月中旬举办的香港国际创科展上,华为搭建了囊括七大主题的面积约600平方米的“豪华展区”。

从智慧城市、行业数字化转型乃至新型储能,华为依托自身端、管、云协同的基础设施优势,眼下正在不断加速向各行各业拓展边界。而在涵盖30余种解决方案的展区中,AI计算相关产品吸引了不少来往展商与观众。“我之前都不知道,华为也有AI训练卡吗?你们的盘古大模型是用自己的产品训练出来的吗?”在华为AI计算的展区内,记者看到有观众如是询问现场的工作人员。

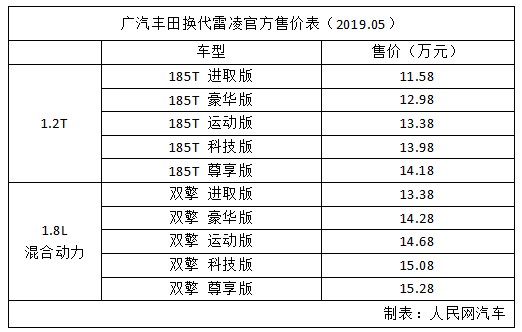

(资料图片)

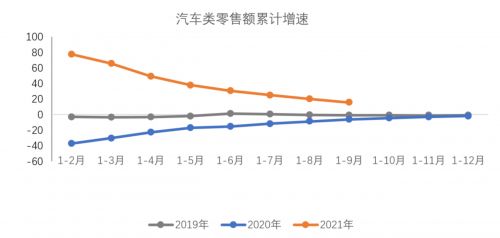

(资料图片)

自ChatGPT的爆火掀起生成式AI的浪潮以来,各类大模型如雨后春笋般冒出,面对正在舞台上卖力演出的“角儿”们,真正搭台的AI算力产业反倒显得不那么引人注目。

“人工智能的核心说起来就三个点:大数据、大模型、大算力,现在国内的算力市场非常火热,像我们合肥(超算)中心的算力已经被国内一家知名智能语音企业全部定下来了,而且客户还要求我们尽快做下一步扩容。”华为展区内一位专家向经济观察报记者介绍。

如果将2023年视为中国人工智能大模型应用元年,那么在大规模的前端产品落地后,算力建设能否及时跟上,便成了大模型向各领域进一步渗透的关键因素。但在部分业内人士看来,眼下国内算力供给已成为制约大模型发展的瓶颈之一。

4月19日,一位来自上海的云计算厂商的产品经理李实在交流时就告诉记者:“目前AI对算力需求增长的速度要快于算力供给增长的速度,AI芯片的迭代也有点跟不上模型训练及迭代所需。”

算力的需求

OpenAI自发布ChatGPT以来,月活用户已在年初突破一亿,成为历史上用户增长最快的应用程序,而在Chat-GPT面世后,与曾经出现的造手机、造汽车的浪潮一样,国内一众互联网产业链上的厂商开始扎堆“造模型”。

先是百度于3月16日官宣发布基于百度飞桨深度学习平台和文心知识增强大模型打造的——文心一言,随后4月9日至11日连续三天,三六零(601360.SH)、商汤、阿里又分别发布了“360智脑”“日日新”“通义千问”三个大模型。此外,腾讯、华为、知乎、京东、昆仑万维也纷纷携带各自的大模型产品加入混战。

但在李实看来,国产大模型的密集发布宣传意义更大,而目前实际落地的使用效果和市场期待尚有一定差距。比如,此前文心一言饱受调侃的作图功能就很能说明一些问题:让其画老婆饼结果真画出来一个老婆婆,画红烧狮子头结果画出来一幅红色的狮子头。

“通用大模型的看点,主要在于未来与不同行业结合后,对各类产品的赋能和提升,比如搜索引擎和大模型的结合,就让这类早已成型的应用又诞生出了想象空间,又或者类似苹果Siri这类语音助手,和大模型结合后带来的沉浸式交互体验是前所未有的。可以说大模型的出现,给许多早已一潭死水的TMT产业带来新的增量空间。”李实说。

在4月18日举办的2023年中国ICT市场趋势论坛上,IDC中国研究总监卢言霞亦称,根据斯坦福大学2022年发布的人工智能指数报告,大模型文生图的准确率仅为25%,而目前文生图、文生文可以落地的一些应用,主要集中在互娱和游戏场景当中,包括影视渲染、美术设计等,真正到工业环境中,市场对于哪些应用场景能够落地,现在还比较困惑。

之所以国内一众大模型的体验效果要逊色于ChatGPT,除了算法及数据方面的差距外,算力投入也是一个绕不开的原因。

CIC灼识咨询合伙人赵晓马向记者表示,人工智能的发展趋势是大数据、大模型,“大力出奇迹”。“过去几十年人工智能的发展无不说明了这一点,每一次数据量级、模型规模的突破,都带来了人工智能技术的突出成果。而这背后,正是AI训练的算力指数级增长。从2010年深度学习出现以来,用于AI训练的算力以每6个月翻一倍的速度增长,2015年前后,大规模模型出现至今,其训练算力都是原来的10倍到100倍。”赵晓马指出。

算力的飙升自然也带来了成本增长,根据国盛证券在今年2月12日发表的一份研报中的测算,在初始算力投入上,为满足ChatGPT当前千万级用户的咨询量,投入成本约为8亿美元,对应约4000台服务器;在单日运行电费上,参考美国平均0.08美元/kwh工业电价,每日电费约为5万美元。此外,基于参数数量和token(字符串)数量估算,GPT-3训练一次的成本约为140万美元。

4月8日,浙江大学人工智能研究所所长吴飞在“人工智能大模型技术高峰论坛”上指出,ChaGPT在训练中使用了45TB数据、近1万亿个单词(约1351万本牛津词典所包含单词数量)以及数十亿行源代码,其模型包含了1750亿参数,将这些参数全部打印在A4纸张上,一张一张叠加后,叠加高度将超过上海中心大厦632米高度,其训练门槛是1万张英伟达V100芯片、约10亿人民币,模型训练算力开销是每秒运算一千万亿次,需运行3640天。“(在人工智能的训练中)数据是燃料、模型是引擎、算力是加速器,据估计全球高质量文本数据的总存量在5万亿token(字符串)左右,人工智能算法可能在一个数量级内,耗尽世界上所有有用的语言训练数据供应。”吴飞称。

庞大的算力需求为AI算力产业带来了广阔的市场空间,根据 IDC数据与预测,2021年中国智能算力规模达到155.2EFLOPS(每秒一百亿亿次的浮点运算)并在之后的几年始终保持稳健增长态势,预计到 2026年将突破进入每秒十万亿亿次浮点计算级别,智能算力实现1271.4EFLOPS的庞大规模,2021-2026年期间,预计年复合增长率达到 52.3%。

一位华为AI计算领域的专家在创科展现场也告诉记者,目前市场对智能算力的需求非常火爆,公司基于昇腾系列AI处理器已经构筑起包括Atlas系列模块、板卡、小站、服务器、集群等丰富的产品形态,覆盖深度学习领域推理和训练全流程,且在全国18座城市都已布局人工智能计算中心,可用于各行业人工智能深度学习模型开发、训练和推理等应用场景。

底座的瓶颈

在李实看来,算力是人工智能领域的铲子,也可以称之为行业底座。

他告诉记者,按照对计算精度要求的不同,算力通常分为通用算力、智能算力以及超算算力。其中,通用算力一般就是基于普通CPU芯片集成的服务器所能提供的算力,用于一些基础的计算场景,而智能算力则是基于GPU、GPGPU及AISC等AI芯片所提供的算力,主要用于人工智能的训练和推理。

一位上海的AI芯片初创企业项目经理唐坤向记者介绍称,当下市场主流的AI芯片均为GPGPU,属于GPU(图形处理器)的一种,它弱化了GPU关于图形处理的功能,来完成原本由CPU承担的任务。

“AI领域的计算需求具有大运算量、高并发度、访存频繁的特点,GPGPU因其多内核多通道的设计,非常适合对大量数据进行并行计算,从而在人工智能领域找到了应用场景。”唐坤表示。

根据市场调研公司Tractica的研究报告,到2025年,全球人工智能芯片的市场规模将达到726亿美元,年均复合增长率达46.14%。

“AI将成为未来高性能计算领域的主要需求。”唐坤说。

但国内一众大模型“卷”于发布的当下,作为行业底座的算力却先遇到了瓶颈。

首先是关于产品本身,李实告诉记者,随着摩尔定律日渐趋近失效,在IC(集成电路)器件本身尺寸不断接近物理极限的情况下,依靠提升晶体管密度从而带来性能提升的难度在不断提高,且AI算力的需求增速已经快于芯片算力的增速。

其次,由于AI模型参数量的不断扩大,AI芯片的内存增速也难以匹配,这导致了内存墙问题的出现,即内存容量限制了芯片性能的发挥。

“前段时间马斯克不是联名要求暂停训练AI嘛,但他不呼吁也没关系,OpenAI也需要暂停一下,等一等硬件迭代。”李实说。

在他看来,AI芯片的未来迭代方向主要将围绕存算一体,即赋予存储器计算能力,大幅降低功耗的同时,显著提高芯片的计算能力。

除了硬件方面有待迭代外,当下的外部环境也为国产算力产业的发展带来了不少限制。

据唐坤介绍,在高端GPU领域,英伟达占据着超过90%的市场份额,ChatGPT即是用上万张英伟达A100芯片打造超算中心训练而出。根据英伟达官网数据,A100的单精度峰值计算性能达19.5TFLOPS(每秒一万亿次的浮点运算)。而一张40G显存的A100芯片,在京东平台上所标售价就达6.25万元。因此,A100芯片也一直被广大科技发烧友戏称为“小金砖”。

另外,值得注意的是,在今年的3月21日,英伟达已经发布了最新一代的H100芯片,相较于前代产品,H100单精度峰值计算性能达67TFLOPS,其双精度的每秒浮点运算(FLOPS)提升3倍,性能提高了约7倍,在动态编程算法上比仅使用传统双路CPU的服务器快40倍。

不过,根据去年10月美国商务部发布的管制条例,A100、H100这类代表国际先进计算水平的芯片已经被禁止售往中国,而2017年发布的V100芯片,因其性能较低,则不在管控之内。“国内厂商还有渠道能够购买英伟达的产品,但短期肯定会对国内的算力产业形成压制。在这个领域,包括寒武纪、海光、华为等企业也在快速发展,但距离实现算力的国产替代还有一定距离。”李实告诉记者。

唐坤则表示,其在今年拓展项目时了解到,当前国内众多超算中心进行产品采购或招标时,都有相应的国产产品指标,而从硬件性能角度来看,不论寒武纪、华为还是海光,均有计算指标不弱于英伟达A100的产品。

根据寒武纪2022年半年报披露,该公司第三代云端产品思元370,采用台积电7nm先进制程工艺,也是首款采用Chiplet(芯粒)技术的人工智能芯片。其单精度峰值计算性能达18TFLOPS(每秒一万亿次的浮点运算)。

“AI芯片领域的国产替代是大趋势,但生态及厂商技术还需要一个提升的过程,而且现在很多企业也在抓紧囤英伟达的相关产品,‘算力荒’的情况应该不会出现。”唐坤说。

政策的扶持

4月19日,上海市经济信息化委印发《上海市推进算力资源统一调度指导意见》。文件指出,算力是夯实科创城市基础、加快城市数字化转型、推动数字经济高质量发展的核心生产力;加强全市算力资源统筹、调度和共享,有助于提升算力资源利用率,加速数据要素流通,全面释放数据价值。

根据文件要求,到2023年底,依托上海市人工智能公共算力服务平台,接入并调度4个以上算力基础设施,可调度智能算力达到1000PFLOPS(FP16半精度每秒一千万亿次的浮点运算)以上;到2025年,市人工智能公共算力服务平台能级跃升,完善算力交易机制,实现跨地域算力智能调度,通过高效算力调度,推动算力供需均衡,带动产业发展作用显著增强,该市数据中心算力超过18000PFLOPS(FP32单精度每秒一千万亿次的浮点运算);新建数据中心绿色算力占比超过10%(不含市电结构中的绿电);集聚区新建大型数据中心综合PUE降至1.25以内,绿色低碳等级达到4A级以上。

今年2月,成都市直接拿出了“真金白银”对算力产业进行扶持,根据成都市新经济委、市经信局、市发改委、市科技局联合印发的《〈成都市围绕超算智算加快算力产业发展的政策措施〉实施细则(征求意见稿)》,成都市政府支持企事业单位、科研机构基于国家超算成都中心技术框架开发通用适配硬软件,根据使用量与频次综合排名,分级分类给予排名前10的单位最高100万元,每年累计不超过500万元的一次性奖励。

文件中还要求开展云计算中心优化行动,推动以存储为主的“老旧”数据中心向以存算为核心的云计算中心提档升级,推动“小散”数据中心融合、迁移至新型数据中心,强化绿色节能和智能化运维,提升大规模数据“云端”分析处理能力。对于改造升级完成后计算功能占比大于 70%且机架数不低于1000架、PUE低于1.25的云计算中心,按照每个机架最高1000元,给予总额最高200万元的一次性改造补贴。

实际上,早在2021年,国家发改委便提出了全国一体化算力网络国家枢纽节点建设规划,根据发改委新闻发言人孟玮在2021年6月17日的例行发布会上介绍,国家发展改革委会同有关部门在京津冀、长三角、粤港澳大湾区、成渝、贵州、内蒙古、甘肃、宁夏等地布局建设全国一体化算力网络国家枢纽节点。

“这8个枢纽节点,将作为我国算力网络的骨干连接点,统筹规划数据中心建设布局,发展数据中心集群,开展数据中心与网络、云计算、大数据之间的协同建设,并作为国家‘东数西算’工程的战略支点,推动算力资源有序向西转移,促进解决东西部算力供需失衡问题。”孟玮表示。

据记者查询,包括成渝、甘肃、宁夏等地的算力枢纽节点均已规划开工,而进展较快的如贵州,其一期基地设备已安装完毕,大约56PFLOPS在4月底就可实现交付。

除了国家规划外,中东部各经济发达地市也都在算力领域掀起“大干快上”的浪潮,根据公众号“宁波发布”的信息,今年1月10日,宁波市首个人工智能超算中心项目(一期)正式上线,一期建成100PFLOPS(FP16半精度每秒一千万亿次的浮点运算)人工智能算力,加5PFLOPS(FP64双精度每秒一千万亿次的浮点运算)计算算力。

记者了解到,截至4月20日,国内已建成并运营人工智能计算中心的城市 共 有 7座 , 分 别 是 深 圳(1000PFLOPS 算 力 )、 武 汉(200PFLOPS算力)、西安(300PFLOPS算力)、成都(300PFLOPS算力)、许昌(100PFLOPS算力)、南京(40PFLOPS算力)、杭州(40PFLOPS算力)。

李实告诉记者,目前智算中心的门槛为100PFLOPS,布局方面以东部为主,但在“东数西算”的大战略下,未来西部也将成为重要的算力布局区域。

“人工智能将成为驱动各行各业发展的引擎,而算力就是这台引擎烧的油,只有油给够,引擎才能转得快不是?”他跟记者比喻说。

关键词: